Seconda puntata del punto di vista dell’Osservatorio dedicato alla regolazione dei sistemi di intelligenza artificiale tra tutela della riservatezza e tutela dell’ambiente.

Le Linee guida pubblicate dalla Commissione europea il 4 febbraio 2025, volte a garantire l’applicazione coerente, efficace e uniforme del Regolamento (UE) 2024/1689, contengono gli orientamenti relativi alle pratiche di IA ritenute inaccettabili a causa dei loro potenziali rischi per i valori e i diritti fondamentali europei. Nonostante le Guidelines forniscano un prezioso contributo ai fini dell’interpretazione dell’AI Act, rimangono aperti alcuni interrogativi, soprattutto per quanto riguarda il rapporto tra tutela della riservatezza e applicazioni di intelligenza artificiale vietate a norma dell’art. 5 del Regolamento.

Le Guidelines on prohibited artificial intelligence practices established by Regulation EU 2024/1689 – AI Act della Commissione europea, pubblicate all’inizio di febbraio 2025, sebbene non abbiano carattere vincolante, costituiscono una rilevante integrazione rispetto alle norme espresse nel Regolamento sull’intelligenza artificiale. Le Linee guida forniscono elementi interpretativi essenziali ai fini dell’applicazione dell’articolo 5 dell’AI Act, che stabilisce l’elenco tassativo delle pratiche di intelligenza artificiale vietate (per un esame delle maggiori questioni giuridiche legate al Regolamento (UE) 2024/1689, si veda il Punto di vista dell’Osservatorio introdotto da B. Carotti, Punti di vista: l’AI Act – Introduzione). L’articolazione del documento appare coerente con la necessità di delineare un quadro normativo capace di prevenire utilizzi dell’IA che possano compromettere significativamente i diritti fondamentali, la sicurezza pubblica e il principio di non discriminazione (sul rapporto tra intelligenza artificiale caratterizzati da rischio inaccettabile e tutela dei diritti fondamentali, V. De Santis, Identità e persona all’epoca dell’intelligenza artificiale: riflessioni a partire dall’AI Act).

Le Linee guida evidenziano il ruolo fondamentale svolto dall’articolo 5 all’interno dell’impianto del Regolamento. Tale articolo comprende tra i propri divieti i sistemi che utilizzano tecniche subliminali che sfruttano le vulnerabilità di una persona fisica, le tecniche di social scoring, le valutazioni del rischio relative a persone fisiche al fine di valutare la probabilità che un individuo commetta un reato, lo scraping non mirato di immagini facciali da internet o da filmati di telecamere a circuito chiuso, i sistemi per inferire le emozioni di una persona fisica nell’ambito del luogo di lavoro e degli istituti di istruzione, i sistemi di categorizzazione biometrica e i sistemi di identificazione biometrica remota in tempo reale in spazi accessibili al pubblico. Le Linee guida analizzano nel dettaglio le otto categorie di pratiche vietate, chiarendone la portata applicativa e le eventuali eccezioni (in merito a trattamenti biometrici e riconoscimento facciale, si veda la ricostruzione di G. Delle Cave, “Non puoi nasconderti, io ti vedo!” Brevi considerazioni su trattamenti biometrici, riconoscimenti facciali e relative (giuridiche) paresi).

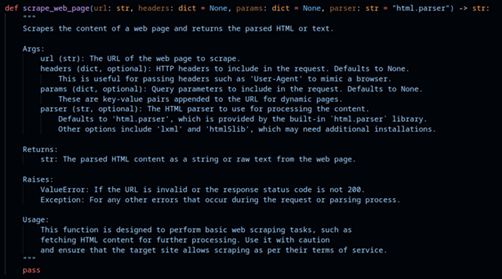

Per quanto riguarda lo scraping di dati biometrici e il riconoscimento facciale, alla luce della proibizione della raccolta indiscriminata e senza consenso di dati biometrici per la creazione di database di riconoscimento facciale, le Linee guida non fornirebbero una definizione esaustiva dei limiti di legittimità dell’impiego di immagini biometriche per l’addestramento di modelli di IA, lasciando aperta la possibilità di possibili conflitti normativi. Le finalità per cui può essere impiegato il web scraping sono numerose, alcune delle quali connotate come malevoli da parte del Garante per la protezione dei dati personali. Tra queste figura anche l’addestramento di algoritmi di intelligenza artificiale generativa, attività che può essere svolta mediante l’utilizzo di ampi dataset ottenuti attraverso uno scraping autonomo oppure attraverso lo sfruttamento di data lake di terze parti, a loro volta creati mediante operazioni di scraping. In alcuni casi i dataset di addestramento possono essere costituiti da dati già in possesso degli sviluppatori, come nel caso dei dati degli utenti di servizi offerti dal medesimo sviluppatore o dei dati degli utenti di un social network, aumentando la distanza tra la finalità per cui i dati erano stati raccolti e la finalità per cui sono stati successivamente impiegati (riguardo alle pratiche di web scraping realizzate da Clearview A.I., sanzionate dal Garante per la protezione dei dati personali, si veda C. Ramotti, Il Garante per la privacy italiano sanziona Clearview A.I.).

Il divieto di sistemi di IA per classificare gli individui in base a comportamenti sociali, personali o professionali, qualora ciò comporti trattamenti ingiustificati o discriminatori (social scoring) e il divieto di sistemi di IA che valutano il rischio di commissione di reati basandosi esclusivamente su profilazione automatizzata o caratteristiche personali (predizione del rischio criminale) assumono particolare rilievo in rapporto alla protezione dei dati, nonché rispetto ai principi di proporzionalità e non discriminazione. Tali sistemi possono infatti condurre a pregiudizi automatizzati, con un impatto significativo sulla presunzione di innocenza (per un’analisi della risoluzione del 6 ottobre 2021 del Parlamento europeo, relativa all’utilizzo dell’intelligenza artificiale nel diritto penale, si veda N. Posteraro, Una risoluzione del Parlamento europeo sull’uso dell’intelligenza artificiale nel diritto penale).

Le Linee guida definiscono il social scoring con una maggiore accuratezza rispetto al testo dell’AI Act: il divieto non si applica a ogni forma di classificazione algoritmica, ma esclusivamente ai sistemi che generano effetti negativi ingiustificati e sproporzionati in ambiti diversi da quelli in cui è stato originariamente calcolato il punteggio. Tale precisazione è fondamentale per evitare un’applicazione eccessivamente restrittiva della normativa, ma allo stesso tempo apre a possibili ambiguità, soprattutto nei casi in cui i dati raccolti da un determinato servizio vengano utilizzati per condizionare aspetti della vita di un individuo diversi da quelli per cui i dati erano stati raccolti. Un sistema di rating finanziario, ad esempio, rientrerebbe automaticamente nel divieto se i suoi output fossero utilizzati in modo improprio in altri contesti sociali (M. Iaselli, Prime disposizioni dell’AI Act in vigore: l’art. 5 e le Linee Guida sulle pratiche di IA vietate).

La proibizione dell’impiego di sistemi di riconoscimento biometrico in tempo reale per finalità di law enforcement negli spazi pubblici costituisce una delle disposizioni più restrittive dell’AI Act e si dimostra in linea con il quadro di tutele delineato dal GDPR in materia di trattamento dei dati biometrici. La previsione di deroghe per finalità di prevenzione di gravi minacce alla sicurezza pubblica solleva tuttavia complessi interrogativi riguardanti il bilanciamento tra le esigenze di sicurezza pubblica e la tutela del diritto alla riservatezza, con particolare riferimento alla necessità di definire criteri oggettivi per la valutazione della proporzionalità delle misure adottate (su riconoscimento facciale e principio di proporzionalità, S. Del Gatto, Riconoscimento facciale e diritti fondamentali: quale equilibrio?). In tale contesto, potrebbero rivelarsi particolarmente utili alcune disposizioni dell’AI Act in materia di sistemi ad alto rischio e l’art. 35 GDPR, norme che prevedono specifici obblighi in merito alla documentazione e alla registrazione delle attività di trattamento, nonché la necessità di effettuare valutazioni d’impatto preventive sui diritti fondamentali (A. Agostini, G. Minucci, G. Lombardi, Le linee guida della commissione sulle pratiche di intelligenza artificiale vietate: analisi generale e profili di privacy).

Le Linee guida della Commissione, pur non risolvendo in modo esaustivo ogni questione interpretativa sollevata dall’AI Act, offrono dunque rilevanti indicazioni per tutelare i cittadini europei dagli esiti maggiormente lesivi del progresso nei sistemi di intelligenza artificiale. Lungo il corso dei prossimi mesi, la sfida principale per l’Unione europea consisterà nell’elaborazione dei necessari sviluppi e integrazioni rispetto agli orientamenti espressi nelle Linee guida, soprattutto sulla base della prassi e delle precisazioni fornite dalle autorità indipendenti, nel tentativo di raggiungere un equilibrio tra la promozione dell’innovazione tecnologica e la tutela dei diritti fondamentali. Tale bilanciamento appare incerto per via della sua mobilità: l’innegabile margine interpretativo lasciato dalle Linee guida, se declinato verso una diminuzione della soglia di protezione o una sfocatura dei divieti di cui all’art. 5 dell’AI Act, potrebbe inevitabilmente compromettere i diritti fondamentali o abbassarne i livelli di tutela, come nel caso delle ambiguità interpretative ravvisate in relazione alle tecniche di social scoring.

Osservatorio sullo Stato Digitale by Irpa is licensed under CC BY-NC-ND 4.0